LLM 项目悄然改变科技行业

超过 1 年前

AI 近年来发展迅速。我认识的每一个关注这一话题的用户或创作者都对 AI 工具的快速演变感到惊讶。如果你想自己制作 AI 工具,我认为这是一条更好的道路,你需要了解这些工具背后的技术。这些技术包括大型语言模型(LLM)系统以及如何使用这些工具进行构建的相关知识。

构建自己的工作流程或 AI 代理是未来的发展方向,适合那些愿意花时间和精力去理解的人。即使你现在还没有达到这个水平,你也应该了解这些特定的工具,因为它们构成了今天许多系统的基础。

请查看一下,并在评论中告诉我你的想法。

进一步阅读:

除了我在 Medium 上的文章,我还热衷于分享 AI 和生产力领域的知识和资源。对于那些希望跟上 AI 和开源最新动态的人:

我还写了一份 AI/开源通讯 BrainScriblr。

如果你想要一份 AI 笔记应用的列表 可以试试这里。

或者,如果你使用 Notion,你可以查看我关于使用 Notion 构建网站的工具列表 在这里。

语义内核

Semantic Kernel 是微软开发的开源软件开发工具包(SDK),旨在使用传统编程语言(如 C#、Python 和 Java)将大型语言模型(LLM)集成到应用程序中。它充当中间件,使开发者能够高效地构建 AI 代理并将最新的 AI 模型集成到现有代码库中。

亮点:

- Semantic Kernel 是开源的,允许开发者修改和扩展其功能。

- SDK 支持本地函数(用传统编程语言编写)和语义函数(使用自然语言定义)。

- 内核 包含一个内存系统,使用嵌入存储语义知识,有助于保持上下文并提高 AI 响应的相关性。

- 通过利用 LLM,Semantic Kernel 提高了聊天机器人的自然语言理解和响应能力,使互动更加生动和具有上下文意识。

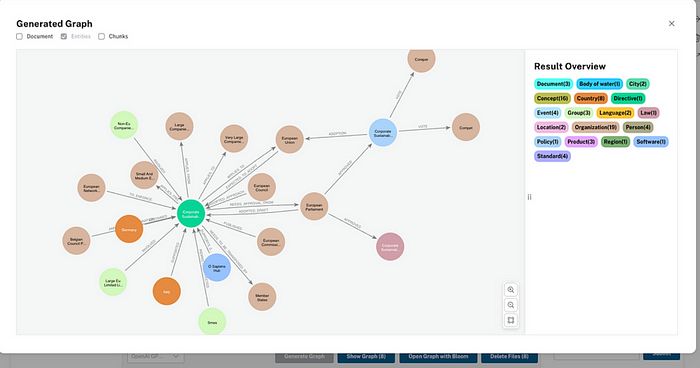

LLM 知识图谱构建器

LLM 知识图谱构建器 是 Neo4j 开发的一种新工具,可以将非结构化文本转换为结构化知识图谱,而无需任何编码。该工具是 Neo4j 的 GraphRAG 生态系统的一部分,旨在利用大型语言模型(LLM)如 OpenAI、Gemini 和 Diffbot,从各种数据源(如 PDF、网页和 YouTube 视频)中创建知识图谱。

亮点:

- LLM 用于识别和提取非结构化文本中的实体及其关系。

- Neo4j LLM 知识图谱构建器 特别适用于创建增强检索生成系统的知识图谱。

- 直观的网页界面使用户能够与应用程序互动,可视化生成的图谱,并与检索增强生成(RAG)代理进行交互。

- 该应用程序使用 Docker 打包前端和后端,可以使用

docker-compose启动。

Llama 模型

LLaMA 模型是由 Meta AI 开发的一系列大型语言模型(LLM),旨在执行各种自然语言处理任务。这些模型基于变换器架构,并且是自回归的,意味着它们根据前面的单词预测序列中的下一个单词。LLaMA 代表 Large Language Model Meta AI。

亮点:

- LLaMA 1:LLaMA 的初始版本以非商业许可证发布,主要用于研究目的。它的设计比其他大型模型更小、更高效,参数大小范围从 70 亿到 650 亿。

- LLaMA 2:2023 年发布的这一版本是开源的,适用于研究和商业用途。它包括 70 亿、130 亿和 700 亿参数的模型。LLaMA 2 在约 2 万亿个标记的数据集上进行训练,并包括针对聊天和代码任务的微调版本。

- LLaMA 3 和 3.1:这些版本包括多语言模型,并针对对话用例进行了优化。它们的参数大小为 80 亿、700 亿,甚至高达 4050 亿。LLaMA 3 模型经过指令调优,以在多语言对话场景中提供更好的性能。

Flux

Flux AI 是由 Black Forest Labs 开发的一套文本到图像模型,旨在根据文本描述生成高质量图像。它以其先进的 AI 技术和生成详细、逼真视觉效果的能力而闻名。

亮点:

- Flux Pro:这是一个高端商业模型,专为专业用途设计,提供顶级图像生成能力。

- Flux Dev:该模型是开放权重的,允许进行非商业实验和开发。它在性能和可访问性之间提供了平衡。

- Flux Schnell:该模型经过速度优化,也是开放权重,适合本地开发和个人使用。

- Flux AI 可以生成各种风格的图像,从照片真实到抽象,适用于各种创意应用。

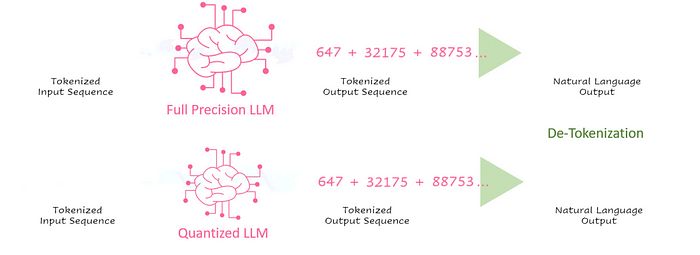

LLM 压缩器

LLM Compressor 是由 Neural Magic 开发的统一库,旨在为大型语言模型(LLM)创建压缩模型,以实现更快和更高效的推理。它旨在简化将压缩技术应用于 LLM 的过程,使其在各种平台上的部署更加可行和实用。

亮点:

- 库 支持多种量化方案,包括激活和权重量化。这使得部署更快,使用 FP8 模型时服务器吞吐量可提高至 3 倍,使用仅权重的 INT4 模型时延迟可提高至 4 倍。

- LLM Compressor 包括权重剪枝技术,以提高性能,稀疏模型的整体性能可提高至 1.5 倍。

- 该库旨在与 Hugging Face 模型配合使用,确保在开源生态系统中的易用性。

- 它与 vLLM 无缝协作,允许压缩模型直接加载和运行,从而简化推理过程。

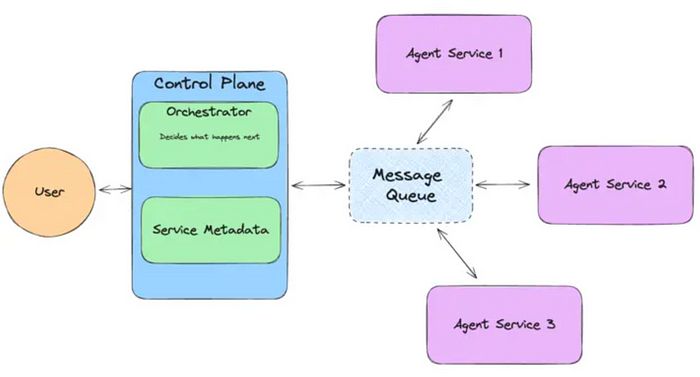

Llama 代理系统

Llama 代理系统是一个框架,旨在运行 Llama 3.1 模型,执行“代理”任务。这些任务涉及多步骤推理、工具使用,以及使用上下文定义学习和调用工具的能力。该系统旨在通过将复杂任务分解为更小的可管理步骤并高效执行来处理复杂任务。

亮点:

- 该系统可以将任务分解为多个步骤,从而实现详细和全面的问题解决。

- 你可以使用命令行界面配置系统,并设置本地服务器以运行代理应用程序。

- 它内置了对各种工具(如搜索引擎和代码解释器)的知识,并可以实时学习使用新工具。

- 安全评估从模型级别转移到系统级别,使其在不同用例中具有更大的灵活性和适应性。该系统包括 Llama Guard,用于输入和输出过滤,以确保安全。

这就是列表。我会继续寻找更多优秀的项目,敬请关注并订阅,以便将我的 Medium 文章直接发送到你的收件箱。如果你想了解更多,这里是链接。

推荐阅读:

FluxAI 中文

© 2026. All Rights Reserved