巨大的 FLUX LoRA 与微调 / DreamBooth 实验已完成。此外,批量大小 1 与 7 的全面对比……

超过 1 年前

巨型 FLUX LoRA 与微调 / DreamBooth 实验已完成

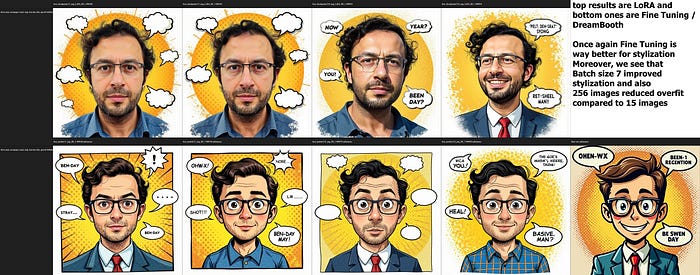

此外,批量大小 1 与 7 也进行了全面测试,不仅针对真实感,还包括风格化——对比了 15 张与 256 张图像的数据集(也测试了表情/情感)——使用了 Kohya GUI 进行训练。

- 完整文件和文章: 点击这里

完整文章链接

- 点击这里

- 文章底部提供了图像

详细信息

- 下载全分辨率图像以查看提示和模型名称

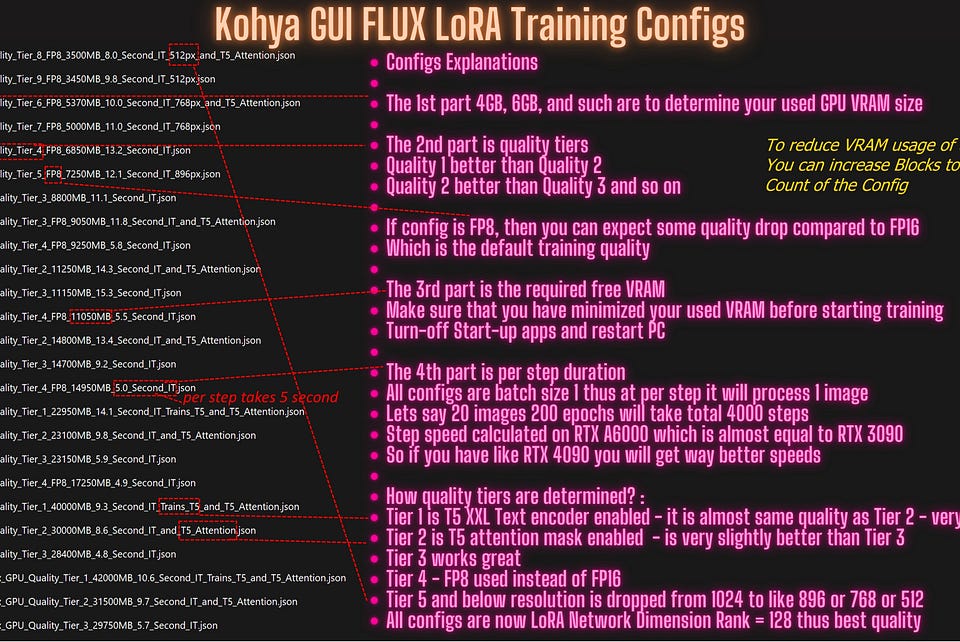

- 所有训练均使用 Kohya GUI 完成,完全可以在 Windows 本地进行,所有训练图像为 1024x1024 像素

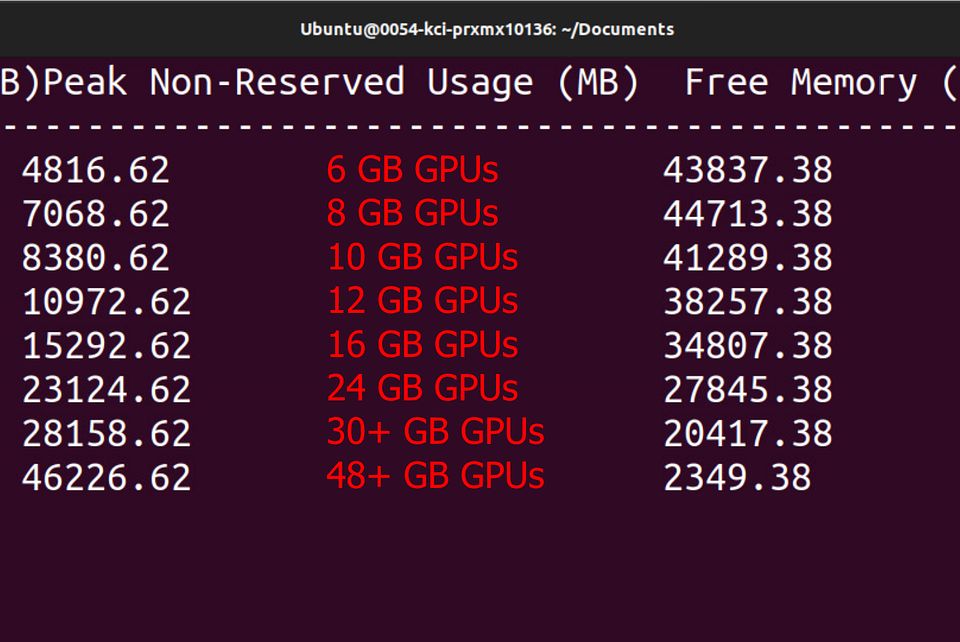

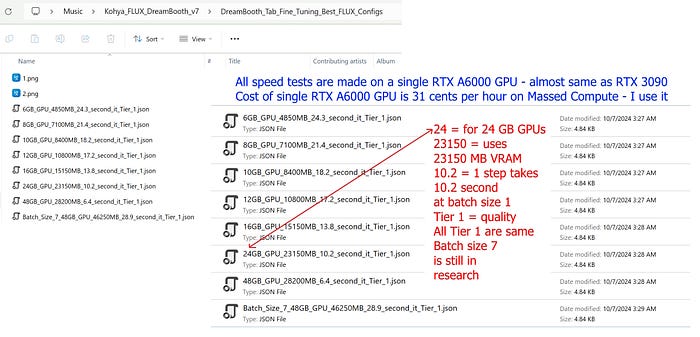

- 微调 / DreamBooth 在 6 GB GPU 上也能正常工作(质量没有下降,完全与 48 GB 配置相同)

- LoRA 的最佳质量需要 48 GB GPU,24 GB 也能很好地工作,最低需要 8 GB GPU(质量会有较大下降)

- 点击这里

- 还分享了以下内容的全尺寸网格:点击这里

- 训练使用了 15 张图像的数据集:15_Images_Dataset.png

- 训练使用了 256 张图像的数据集:256_Images_Dataset.png

- 15 张图像数据集,批量大小 1 微调训练:15_imgs_BS_1_Realism_Epoch_Test.jpg,15_imgs_BS_1_Style_Epoch_Test.jpg

- 15 张图像数据集,批量大小 7 微调训练:15_imgs_BS_7_Realism_Epoch_Test.jpg,15_imgs_BS_7_Style_Epoch_Test.jpg

- 256 张图像数据集,批量大小 1 微调训练:256_imgs_BS_1_Realism_Epoch_Test.jpg,256_imgs_BS_1_Stylized_Epoch_Test.jpg

- 256 张图像数据集,批量大小 7 微调训练:256_imgs_BS_7_Realism_Epoch_Test.jpg,256_imgs_BS_7_Style_Epoch_Test.jpg

- 15 张图像数据集,批量大小 1 LoRA 训练:15_imgs_LORA_BS_1_Realism_Epoch_Test.jpg,15_imgs_LORA_BS_1_Style_Epoch_Test.jpg

- 15 张图像数据集,批量大小 7 LoRA 训练:15_imgs_LORA_BS_7_Realism_Epoch_Test.jpg,15_imgs_LORA_BS_7_Style_Epoch_Test.jpg

- 256 张图像数据集,批量大小 1 LoRA 训练:256_imgs_LORA_BS_1_Realism_Epoch_Test.jpg,256_imgs_LORA_BS_1_Style_Epoch_Test.jpg

- 256 张图像数据集,批量大小 7 LoRA 训练:256_imgs_LORA_BS_7_Realism_Epoch_Test.jpg,256_imgs_LORA_BS_7_Style_Epoch_Test.jpg

比较

- 微调 / DreamBooth 15 张与 256 张图像,批量大小 1 与 7 的真实感比较:Fine_Tuning_15_vs_256_imgs_BS1_vs_BS7.jpg

- 微调 / DreamBooth 15 张与 256 张图像,批量大小 1 与 7 的风格比较:15_vs_256_imgs_BS1_vs_BS7_Fine_Tuning_Style_Comparison.jpg

- LoRA 训练 15 张与 256 张图像,批量大小 1 与 7 的真实感比较:LoRA_15_vs_256_imgs_BS1_vs_BS7.jpg

- LoRA 训练 15 张与 256 张图像,批量大小 1 与 7 的风格比较:15_vs_256_imgs_BS1_vs_BS7_LoRA_Style_Comparison.jpg

- 测试 LoRA 训练的微笑表情:LoRA_Expression_Test_Grid.jpg

- 测试微调 / DreamBooth 训练的微笑表情:Fine_Tuning_Expression_Test_Grid.jpg

微调 / DreamBooth 与 LoRA 比较

- 15 张图像微调与 LoRA,批量大小 1:15_imgs_BS1_LoRA_vs_Fine_Tuning.jpg

- 15 张图像微调与 LoRA,批量大小 7:15_imgs_BS7_LoRA_vs_Fine_Tuning.jpg

- 256 张图像微调与 LoRA,批量大小 1:256_imgs_BS1_LoRA_vs_Fine_Tuning.jpg

- 256 张图像微调与 LoRA,批量大小 7:256_imgs_BS7_LoRA_vs_Fine_Tuning.jpg

- 15 张与 256 张图像,批量大小 1 与 7,LoRA 与微调的比较:15_vs_256_imgs_BS1_vs_BS7_LoRA_vs_Fine_Tuning_Style_Comparison.jpg

- 还分享了完整的结论和建议:点击这里

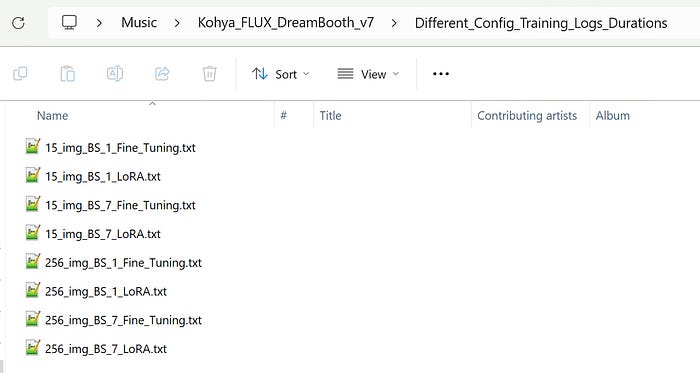

- 此外,我还分享了完整的训练日志,可以查看每个检查点所需的时间。我分享了最佳检查点、它们的步骤计数和所需时间,涵盖了 LoRA、微调、批量大小 1、7、15 张图像或 256 张图像,因此这是一篇非常详细的文章。

- 查看图像以查看帖子中分享的所有文件。

- 此外,提供了非常详细的分析,文章中包含了所有最新的 DreamBooth / 微调配置和 LoRA 配置,并附有适用于 Windows、Runpod 和 Massed Compute 的 Kohya GUI 安装程序。

- 此外,我还分享了新的 28 个真实感和 37 个风格化测试提示。

当前教程如下:

- Windows 环境要求 CUDA、Python、cuDNN 等:点击这里

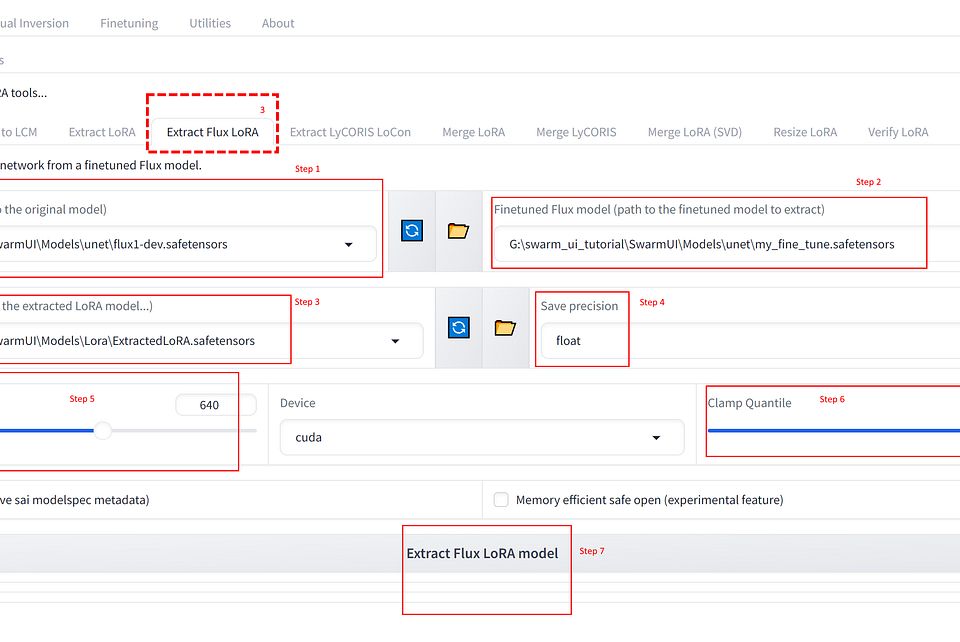

- 如何使用 SwarmUI:点击这里

- 如何在 SwarmUI 上使用 FLUX:点击这里

- 如何使用 Kohya GUI 进行 FLUX 训练:点击这里

- 如何在云端(RunPod 和 Massed Compute)使用 Kohya GUI 进行 FLUX 训练:点击这里

- 希望很快会有新的教程,涵盖这项研究和微调 / DreamBooth 的教程

我进行了以下训练,并进行了全面分析和比较:

- 微调 / DreamBooth:15 张训练图像,批量大小为 1

- 微调 / DreamBooth:15 张训练图像,批量大小为 7

- 微调 / DreamBooth:256 张训练图像,批量大小为 1

- 微调 / DreamBooth:256 张训练图像,批量大小为 7

- LoRA:15 张训练图像,批量大小为 1

- LoRA:15 张训练图像,批量大小为 7

- LoRA:256 张训练图像,批量大小为 1

- LoRA:256 张训练图像,批量大小为 7

- 对于每个批量大小 1 与 7,研究了独特的新学习率(LR),并使用了最佳的学习率

- 然后非常仔细和全面地比较了所有这些检查点,并分享了所有发现和分析

- 巨型 FLUX LoRA 与微调 / DreamBooth 实验已完成,此外批量大小 1 与 7 也进行了全面测试,不仅针对真实感,还包括风格化:点击这里

研究的一部分图像

推荐阅读:

FluxAI 中文

© 2026. All Rights Reserved