"Kohya大神出手!FLUX LoRA性能飞跃,低至4GB显卡也能爽玩!DreamBooth/微调新技巧揭秘!"

大约 1 年前

https://www.patreon.com/posts/110879657 — LoRA 文章

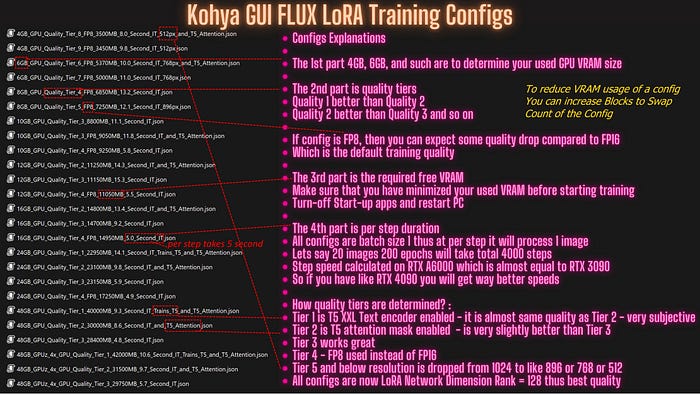

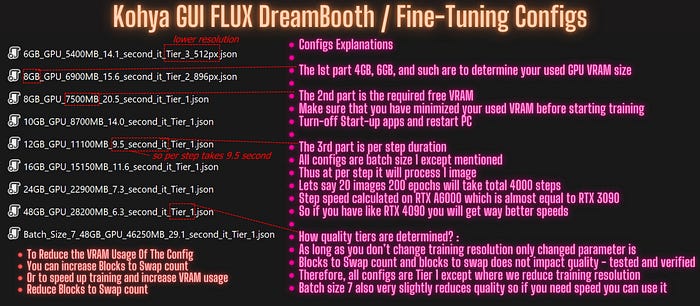

Kohya 对 FLUX LoRA 和 DreamBooth / 微调(最低 6GB GPU)训练带来了巨大的改进。

现在,低至 4GB 的 GPU 也能以不错的质量进行 FLUX LoRA 训练,而 24GB 及以下的 GPU 在进行全 DreamBooth / 微调训练时获得了巨大的速度提升。

你需要至少 4GB 的 GPU 来进行 FLUX LoRA 训练,至少 6GB 的 GPU 来进行 FLUX DreamBooth / 全微调训练。这简直令人难以置信。

你可以下载所有配置和完整说明 > https://www.patreon.com/posts/112099700

上述文章还提供了适用于 Windows、RunPod 和 Massed Compute 的一键安装程序和下载器。

模型下载脚本也已更新,在 Massed Compute 上下载 30+GB 的模型仅需 1 分钟。

你可以在这里阅读最近的更新:https://github.com/kohya-ss/sd-scripts/tree/sd3?tab=readme-ov-file#recent-updates

这是 Kohya GUI 的分支:https://github.com/bmaltais/kohya_ss/tree/sd3-flux.1

减少 VRAM 使用的关键是使用块交换。

Kohya 实现了 OneTrainer 的逻辑,显著提高了块交换速度,现在也支持 LoRAs。

现在你可以在 24GB 及以下的 GPU 上进行 FP16 训练和 LoRAs 训练。

现在你可以在 4GB 的 GPU 上训练 FLUX LoRA — 关键在于 FP8、块交换和使用特定的层训练(记住单层 LoRA 训练)。

我花了超过一天的时间来测试所有新的配置、它们的 VRAM 需求、它们的相对步骤速度,并准备这些配置 :)

全微调教程在这里:https://youtu.be/FvpWy1x5etM

全 LoRA 训练教程在这里:https://youtu.be/nySGu12Y05k

推荐阅读:

FluxAI 中文

© 2026. All Rights Reserved