OpenAI Sora翻车了?网友:就这?

12 个月前

经过漫长的等待,OpenAI 终于发布了他们的终极文本-视频模型 Sora。我还记得,当 OpenAI 宣布 Sora 时,世界首次接触到了文本-视频技术,这引起了所有人的关注。但现在,当它正式发布时,

AI 视频生成已经不再是一个遥远的梦想,已经有多个模型发布,其中一些甚至是开源的。

然而,从 Sora 的发布方式来看,我感到有些失望,我觉得 OpenAI 似乎在试图榨取其声誉。

订阅 datasciencepocket 的 Gumroad 页面,致力于向每个人教授 AI 知识 !gumroad.com

以下是我感到失望的几个原因:

又是付费的!

OpenAI 的 Sora 似乎专为付费用户设计。与其名字中的“开放”精神相反,OpenAI 近年来已经逐渐远离了开源创新。现在的重点似乎是将技术商业化,大多数新功能和进展都被锁定在高级订阅之后。虽然这种商业模式确保了持续的发展,但也让许多人怀疑 OpenAI 的核心理念是否已经从开放合作转向了封闭创新。

没有公布性能指标

OpenAI 巧妙地避免了分享其最新工具的任何性能数据。这使得很难将其与竞争对手进行比较,比如开源的 Hunyuan-Video 或闭源的 Luma 或 Gen3 Alpha。通过不透露这些细节,OpenAI 让人们对其产品的表现充满猜测。

生成视频中的异常

OpenAI 的 Sora 生成的图像质量并不总是完美的。 我看到一些技术评论者分享的例子,其中一些细节看起来有点不对劲。例如,手指可能看起来很奇怪,或者图像中的物体可能违背了基本的物理规律,比如阴影与光源不匹配,或者物体不现实地漂浮。虽然整体技术令人印象深刻,但在某些时刻,它并没有完全捕捉到自然或逻辑细节。

没有模型细节/架构

OpenAI 团队选择不透露其最新系统的底层模型架构或使用的数据。 甚至没有提供关于模型如何设计、训练或优化的表面解释。这种缺乏透明度的做法让社区处于黑暗中,无法理解技术的内部工作原理或评估其优势和局限性。

对于开发者、研究人员和爱好者来说,这种保密性使得更难信任模型的能力,与其他替代方案进行比较,或在其基础上进行创新。

有限的定制化

用户对微调或定制模型以适应特定需求的控制很少,这使得它在处理小众或高度专业化的任务时显得不够灵活。

依赖云基础设施

Sora 可能完全在云平台上运行,这可能会引发对数据安全、延迟和可用性的担忧,尤其是对于网络连接不稳定的用户。此外,目前还没有 Sora 的 API。

未知的偏见和数据来源

由于缺乏对训练数据的透明度,用户无法评估数据集中的偏见如何影响输出。这对于那些将 Sora 用于敏感应用(如医疗或教育)的人来说可能是一个问题。如果没有关于 Sora 如何确保道德使用或减轻错误信息、有害内容或滥用的风险的见解,用户可能会犹豫是否将其用于负责任的应用。

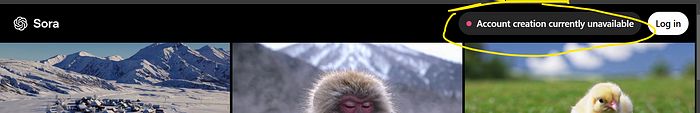

网站流量处理不佳

团队在发布后几小时内停止了新账户的创建。无论原因是什么,我认为本可以以更好的方式处理这个问题。

不过,世界并没有因此终结,因为我觉得现在有很多开源的文本-视频模型,有些甚至比 Sora 更好,可以在本地系统上运行。

最佳 OpenAI Sora 免费替代品

Hunyuan-Video

目前最好的文本-视频模型,完全开源。从性能指标到权重再到 ComfyUI 版本,所有内容都可以在互联网上找到。

LTX

另一个开源模型,LTX-Video 是一个基于 DiT 的模型,用于实时高质量视频生成。它生成 24 FPS 的视频,分辨率为 768x512,支持文本到视频和图像+文本到视频,并在多样化的视频数据集上训练,以产生逼真的输出。权重可在 HuggingFace 上找到。

Mochi-1

Genmo 的 Mochi-1 是另一个优秀的文本-视频模型,资源消耗相对较少,也可在 HuggingFace 上找到。

除此之外,你还可以尝试完全开源的 CogVideoX 和 Pyramid-Flow。

总之,虽然 OpenAI 的 Sora 再次引起了人们对文本到视频技术的关注,但其执行方式却让人感到失望。缺乏透明度、质量不一致和访问受限等问题,使其更像是一个错失的机会,而非突破性的发布。然而,像 Hunyuan-Video、LTX-Video 和 Mochi-1 这样的开源替代方案确保了这一领域的创新仍然对所有人开放。对于那些对 Sora 感到失望的人来说,这些替代方案提供了可行且有前景的前进道路。

推荐阅读:

FluxAI 中文

© 2025. All Rights Reserved