《LLM微调终极指南:一文读懂所有细节!》

12 个月前

掌握微调大型语言模型的艺术与科学:从基础概念到前沿技术的全面指南

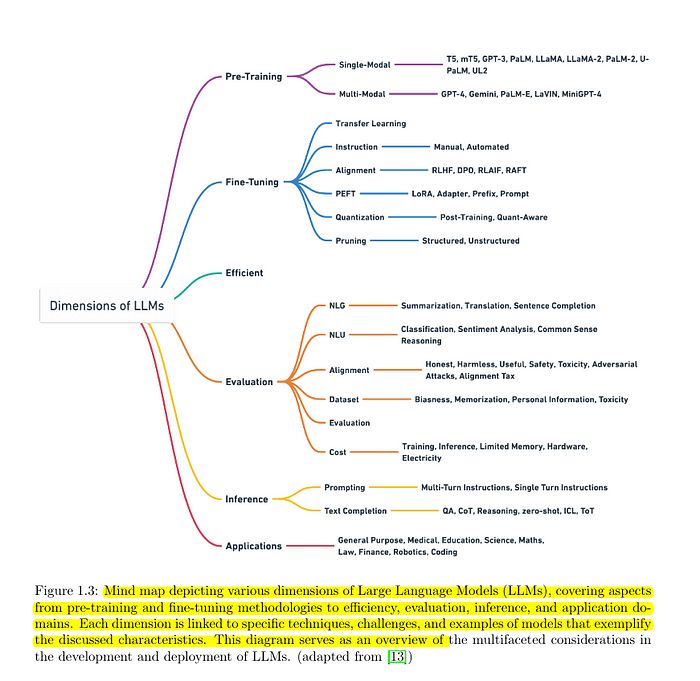

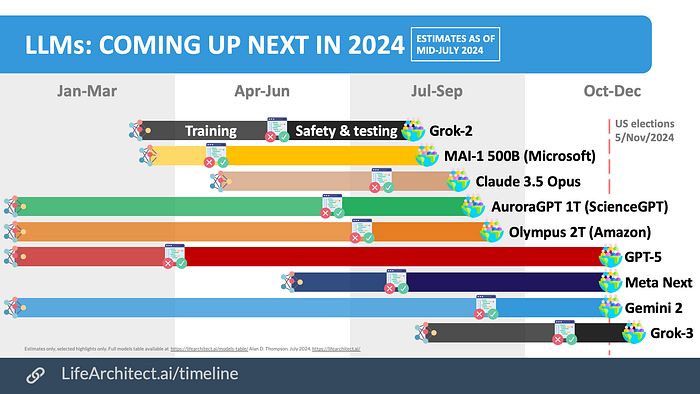

在快速发展的AI领域,微调大型语言模型(LLMs)已成为一项关键技能。通过分析一篇具有开创性的114页研究论文并结合实践经验,以下是2024年关于LLM微调的所有你需要了解的内容。

历史背景:LLMs的演变(1990–2023)

从基本的神经网络到如今复杂的大型语言模型,这一历程令人瞩目。关键里程碑包括:

- 1990年代:早期的神经语言模型

- 2017年:Transformer架构

- 2018年:BERT与预训练革命

- 2019年:GPT系列的出现

- 2022年:指令微调的兴起

- 2023年:高效微调方法的崛起

完整的微调流程

阶段1:数据准备

- 数据集整理与清洗

- 质量评估

- 偏差检测与缓解

- 格式标准化

阶段2:模型选择

- 基础模型评估

- 架构考量

- 资源需求分析

- 许可证与使用权

阶段3:微调策略

- 全量微调 vs. 参数高效微调(PEFT)

- 超参数优化

- 训练目标选择

- 验证方法

阶段4:训练过程

- 计算基础设施设置

- 训练监控

- 检查点管理

- 错误处理

阶段5:评估

- 性能指标

- 基准测试

- 安全性评估

- 偏差评估

阶段6:部署

- 模型压缩

- 推理优化

- 服务基础设施

- 监控设置

阶段7:维护

- 性能监控

- 重新训练策略

- 版本控制

- 文档记录

高级微调方法

近端策略优化(PPO)

关键组件:

- 策略网络

- 价值函数

- 裁剪目标

- 信任区域强制执行

直接偏好优化(DPO)

优势:

- 比RLHF更稳定

- 更快的收敛速度

- 更好的偏好对齐

- 更低的计算成本

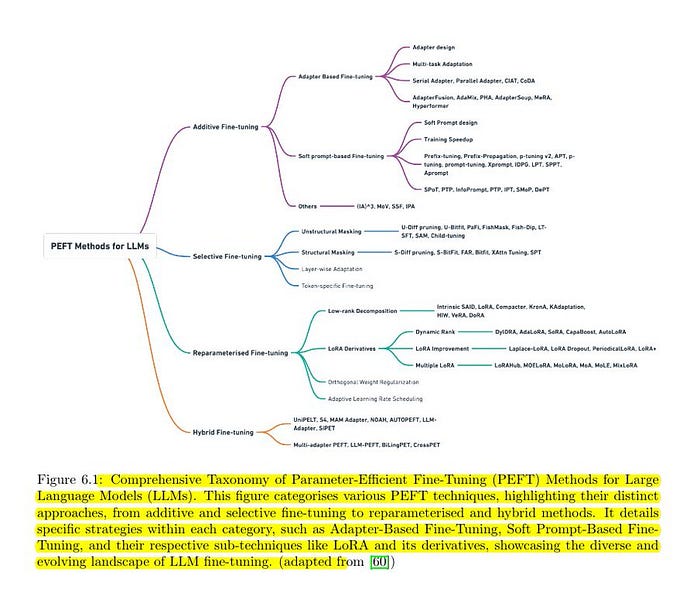

参数高效微调(PEFT)技术

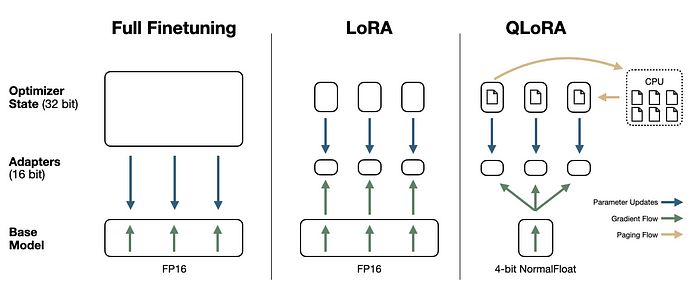

LoRA(低秩适应)

关键特性:

- 低秩分解

- 冻结预训练权重

- 高效内存使用

- 快速适应

QLoRA

创新点:

- 4位量化

- 分页优化器

- 梯度检查点

- 动态内存处理

DoRA

高级特性:

- 权重分解

- 方向-幅度分离

- 改进的适应性

- 增强的性能

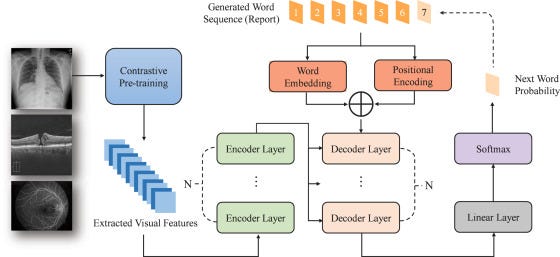

多模态微调

对比预训练

流程分解:

- 文本-图像对编码

- 表示对齐

- 零样本泛化

- 跨模态迁移

评估框架

指标

- 困惑度

- ROUGE分数

- BLEU分数

- 任务特定指标

基准测试

GLUE和SuperGLUE

- 自然语言理解

- 多子任务

- 标准化评估

TruthfulQA

- 事实准确性

- 错误信息检测

- 推理能力

MMLU

- 多任务能力

- 领域专业知识

- 推理深度

安全性评估

使用DecodingTrust:

- 偏差评估

- 毒性检测

- 公平性指标

- 安全性合规

部署策略

优化技术

模型压缩

- 量化

- 剪枝

- 知识蒸馏

推理优化

- 缓存

- 批处理

- 硬件加速

扩展考量

- 负载均衡

- 水平扩展

- 资源管理

领域特定应用

医疗领域

- 临床文本理解

- 诊断辅助

- 医学文献分析

金融领域

- 市场分析

- 风险评估

- 法规合规

可操作的建议

明智开始

- 从PEFT方法开始

- 使用成熟的基准测试

- 监控计算资源

尽早优化

- 实施高效训练

- 尽可能使用量化

- 监控内存使用

彻底评估

- 使用多个基准测试

- 评估安全性指标

- 测试实际性能

继续阅读 →

Max Petrusenko 在软件开发行业远程工作,并环游世界以紧跟最新趋势。他的 Cryptobase 通讯为在这个快速而疯狂的环境中需要采取行动的深思熟虑的人提供了深刻的见解。他还在研究灵性和神秘主义的话题,并将其带入主流。关注他的人可以在 ___,__Twitter_ 和 Substack 上找到他。

**标签:** #机器学习 #LLM #微调 #AI #深度学习 #NLP #模型优化

FluxAI 中文

© 2025. All Rights Reserved