🔥【教程】如何在ComfyUI中运行Flux模型(gguf)并集成LoRA?🚀

大约 1 年前

最近我在使用 Flux 的托管版本来生成图像,但费用相当高。而且 Replicate 也提高了他们的定价,所以我为此支付了不少账单。

我决定在本地生成图像,使用 gguf 格式,因为这种模型格式使模型更紧凑且加载速度更快(使用了先进的压缩技术)。

整个过程分为 4 个部分。

第一部分:下载并运行 ComfyUI,添加 gguf 支持

第二部分:下载工作流并加载到 ComfyUI 中

第三部分:下载模型(TE、VAE、transformer、LoRA)到 ComfyUI 中

第四部分:编写提示词并在 ComfyUI 中运行工作流

第一部分:下载并运行 ComfyUI

从 GitHub 链接下载 ComfyUI: https://github.com/comfyanonymous/ComfyUI?tab=readme-ov-file#installing (我使用的是 Mac Pro,没有 Nvidia GPU,但我仍然可以在大约 3 分钟内运行推理。)

在这一部分的最后,你应该能够在浏览器中启动 ComfyUI。

(creator) macbookpro4:ComfyUI yil$ python main.py

Total VRAM 32768 MB, total RAM 32768 MB

pytorch version: 2.5.1

Set vram state to: SHARED

Device: mps

Using sub quadratic optimization for cross attention, if you have memory or speed issues try using: --use-split-cross-attention

[Prompt Server] web root: /Users/yil/comfyUI/ComfyUI/web

Starting server

To see the GUI go to: http://127.0.0.1:8188

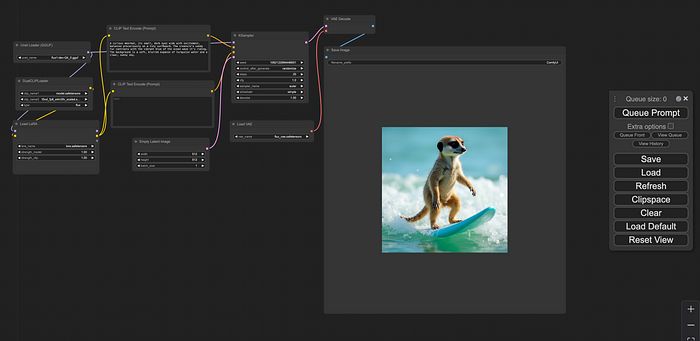

然后访问 http://127.0.0.1:8188,你会看到一个带有这个小控制器的网页。

接下来,我们需要下载 ComfyUI-GGUF 来为 ComfyUI 添加 gguf 支持。你需要进入你的 comfyUI/custom_nodes 目录,使用 git clone 下载 https://github.com/city96/ComfyUI-GGUF 到这个文件夹中。

第二部分:下载工作流并加载到 ComfyUI 中

你可以从这里下载工作流: https://drive.google.com/file/d/1lWsaVtESydGudEakK0CW9C28qHSVOlcu/view?usp=sharing

然后只需点击上面面板中的“Load”按钮,将 json 文件加载到 ComfyUI 中。

第三部分:下载模型(TE、VAE、transformer、LoRA)到 ComfyUI 中

为此,我们首先需要下载一堆模型:

2 个 Clips(文本编码器):

- openai/clip-vit-large-patch14/model.safetensors

- comfyanonymous/flux_text_encoders/t5xxl_fp8_e4m3fn_scaled.safetensors

VAE:

Unet:

LoRA:

然后我们需要将这些模型放到它们各自的位置,两个 clips 模型放在 comfyUI/models/clip 文件夹中,VAE 放在 comfyUI/models/vae 文件夹中,Unet 放在 comfyUI/models/unet 文件夹中,LoRA 放在 comfyUI/models/loras 文件夹中。

第四部分:编写提示词并在 ComfyUI 中运行工作流

推荐阅读:

FluxAI 中文

© 2026. All Rights Reserved