Meta的潜在推理者:AI背后的秘密武器

大约 1 年前

这是不可避免的,Meta 似乎终于理清了思路。

在人工智能模型的众多反直觉特性中,有一个特别“非人类”的处理方式:推理。

事实上,它们通常是非常糟糕的推理者,一个关键原因是它们只能通过语言进行推理。换句话说,它们边说话边思考,而不是像你周二在酒吧里喝醉的朋友那样,先思考再说话,导致结果不佳。

这篇短文将解释大型语言模型(LLMs)或大型推理模型(LRMs)与人类相比如何进行推理,以及 Meta 如何可能将它们拉近到前所未有的程度。

迈向人类水平推理的又一步? 让我们一探究竟。

我让 AI 变得简单,不那么花哨(没有炒作),但对你来说更强大。由一位 AI 专家撰写的通讯——或者至少假装是——拥有 17 万粉丝和数十万每月读者,他们都有独立思考。

点击下方,立即免费开始。

TheWhiteBox by Nacho de Gregorio 在 AI 领域保持领先的通讯 beehiiv.com

推理的源头

想象一下,你必须大声说出脑海中浮现的每一个想法。简单来说,你必须通过生成语言来思考。自然,这毫无意义,并导致糟糕的推理。

而这就是今天 AI 的“思考”方式。

一个惊人的 AI 限制

然而,这就是我们前沿的 AI 模型“推理”的方式。用 AI 术语来说,‘它们在语言空间中推理’,这是一种很酷的方式来描述我刚才所说的。

但 LLM/LRM 内部到底发生了什么?

这些模型是自回归的:它们接收一个词序列,然后逐个输出下一个词。

这个过程涉及四个主要步骤:

- 分块。序列被分解成块。大多数模型使用一个分词器,这是一个学习到的标记(单词或子词)字典,它将整个模型的词汇表分解为固定部分。像 Meta 的 BLT 这样的新模型动态地分块序列,防止静态计算图(想了解更多,点击这里)。专注于分词模型(大多数都是这样),每个块都有一个编号,称为索引。这意味着特定的序列总是以相同的方式分块。

- 使用这个索引,我们自动从嵌入表中获取该标记的嵌入(就像 Excel 中的 VLOOKUP)。这给了我们该标记的向量形式,这对于 AI 处理单词至关重要(它们只理解数字)。

- 处理。模型然后通过不同的层处理这些嵌入,使它们相互交互,形成对序列的总体理解。

这些嵌入在模型内部处理时,以前被称为“潜在”,因为它们是“隐藏”在模型内部的。

4. 解码。一旦处理完成,模型选择下一个词,然后最后一个嵌入被“解码”回语言。这是步骤 2 的相反过程;我们不是将单词转换为向量,而是查看向量形式的选定单词,并通过“解嵌入表”将其“解嵌入”回自然语言。

简而言之,AI 要“思考”就必须“说话”。

相反,人类“在抽象概念的空间中推理”。一旦我们知道要说什么,我们就会表达我们的思考。

但 Meta 可能终于让 AI 做到了“完全相同”的事情。

在潜在空间中的推理

分词的问题在于它不是在训练过程中学习的。用外行的话来说,模型如何处理每个序列的分块是由模型强加的,它只能将词序列分块为预定义的形式。

COCONUT 的不同之处

具体来说,这意味着处理特定输入词组合(如一个句子)的成本总是相同的。

正如我们在对字节级变压器的评论中看到的,同样来自 Meta,这阻止了分词模型(包括 ChatGPT、Gemini 或 Claude 在内的所有模型)主动决定它们愿意在预测中投入多少计算,导致不必要的计算过载。

例如,预测序列中的下一个词,“法国的首都是……” 比 “给我一个中国在 AI 上可能超越美国的理由” 要容易得多。

但如果我们允许模型在做出预测之前思考更长时间呢? 对于第一个例子来说,这没有必要,但像后者这样更复杂的序列会受益于模型在内部思考更长时间后再做出回应。

这就是今天突破的本质:潜在推理模型。

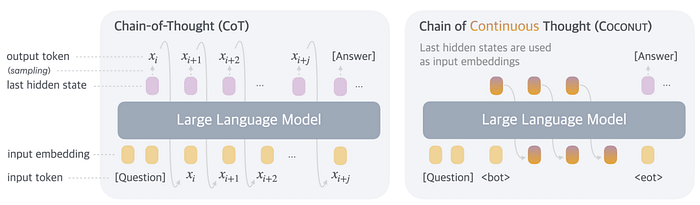

这个想法非常简单:看看上面的四个步骤,与其自动开始解码(步骤 4),我们取最后一个潜在状态并将其重新插入模型中,然后模型处理序列和最后一个潜在状态;我们在步骤三上开始一个循环,只有在模型准备好说话时才进入步骤 4(解码)。

用外行的话来说,模型不是在每次处理结束时生成一个新词,而是将其最后一层的输出重新插入模型以处理下一个,这意味着这些输出不再是语言,而是“思考”。

区别如下所示。像 ChatGPT 这样的标准 LLMs/LRMs 的行为类似于左边的图表。在模型处理序列后,它被迫生成第一个词以继续(‘巴黎’在我们上面讨论的例子中)。

另一方面,COCONUT 模型(右)只有在对其有信心时才会生成用户看到的实际词。

直观地说,区别在于标准模型“边说话边思考”,而 COCONUT 继续在内部处理序列,最终生成一个在生成之前已经分配了更多计算的标记。

换句话说,虽然 o3 在实际答案中生成了思维链(CoT),但 COCONUT 在内部生成 CoT,然后回答,就像人类在沉默中思考然后回答一样。

需要注意的是,这种“思考更长时间”的想法只有在模型认为有必要时才会发生。这可以追溯到我们之前提到的动态计算分配功能,这对于创建更智能和更高效的模型是必要的。如果模型认为它准备好说话了,它就会说。

还要区分我在这里所说的“思考更长时间”的含义,尤其是当我们总是将 LRMs 视为“思考更长时间的 LLMs”时。

关键的区别在于,COCONUT 模型,无论是 LLM 还是 LRM,在内部思考更长时间。相比之下,标准的 LRM 通过生成基于语言的思维链来思考更长时间,在其思考过程中生成更多的输出标记(单词)。然而,标准的 LRM 仍然具有与任何 LLM 相同的缺陷:它需要说话才能思考,这正是我们在这里试图避免的。

更聪明、更深思熟虑

COCONUT 引入的另一个重要特性是更高效的推理。当我们强迫模型边说话边思考时,它还会添加许多增强其流畅性但不一定提供任何额外信息的标记。

例如,模型可能会使用更好的短语动词,玩弄句子以使它们的解释不那么重复,并使用我们添加到语言中的所有其他风格导向的单词,以提供连贯性并使其易于消化。

相反,由于 COCONUT 先思考再说话,它直接切入主题,生成的标记要少得多。

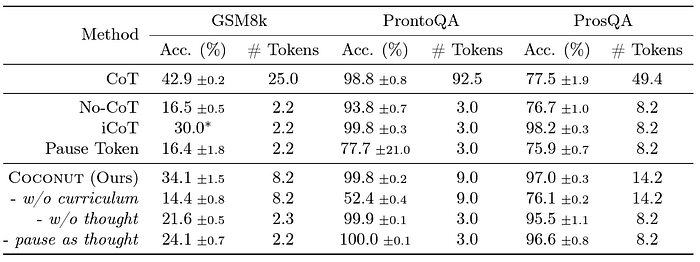

COCONUT 类型的模型平均生成的每个响应的语言标记要少得多。来源:Meta

除了基于流畅性的标记外,当前的 LLMs/LRMs 在解释中非常冗长,因为它们需要说话才能思考,它们用单词来“下定决心”。

这类似于当你问一个人一个问题时,他/她开始咕哝或添加像“呃”或“嗯”这样的声音,以暗示他/她在思考答案,因为那个人得到了一些额外的时间来思考。

这些不必要的推理在与另一个人的对话中是可以容忍的,但当前模型的过度冗长是不可忍受的。由于 COCONUT LLMs 不会被强迫“仅仅因为”而说话,而是在做出第一个预测之前思考更长时间,你:

- 得到一个直击要害并回答你任何问题的响应(也减少了幻觉)。

- 得到一个更深思熟虑的响应,因为模型在说出第一个词之前已经在内部生成了思维链。

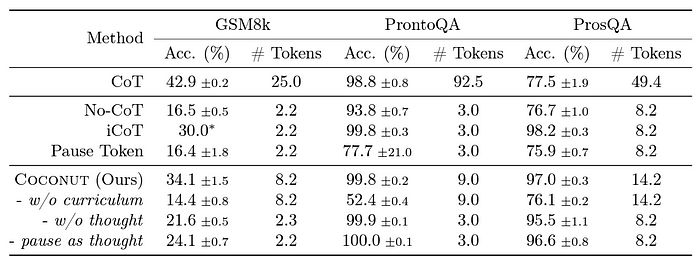

总的来说,COCONUT 大大提高了模型的推理能力(尽管我们不能这么早下结论,因为在某些情况下标准的 CoT 表现更好,这对于一个新的算法突破来说并不奇怪)。

COCONUT 在几乎所有任务中都显示出推理改进。来源:Meta

尽管如此,它在推理任务中的表现,尤其是在规划方面,表明这可能是 AI 模型的未来。它们的推理效率提高了 10 倍以上,而且坦率地说,它们的行为更像人类,这是一个很好的迹象。

潜在推理模型,即在说话之前思考的模型,将长期存在。

进步只会加速

COCONUT 证明 AI 仍然处于早期阶段。好消息是,我们正在以前所未有的速度前进。

重要的是,AI 正在慢慢缩小效率差距,使其计算更加高效。这对于使这些模型在现实生活中可用至关重要。

2025 年将是 AI 历史上最重要的一年。记住我的话;这仅仅是开始。

有关 AI 战略或分析的商业咨询,请联系[email protected]

如果你喜欢这篇文章,我在 LinkedIn 上以更全面和简化的方式免费分享类似的想法。

推荐阅读:

FluxAI 中文

© 2026. All Rights Reserved