本想挑战LLM,结果却成了用户调研好搭档!发生了什么?

大约 1 年前

我本想挑战大语言模型,结果我们成了用户研究的好搭档。以下是事情的经过。

我让 ChatGPT 经历了一系列测试,看看它在分析定性数据方面的表现如何,结果彻底改变了我对它在用户研究中的应用看法。

现在是2029年,机器已经接管了世界并摧毁了人类。AI军事车辆在一片曾是洛杉矶的沙漠中碾压着人类的头骨,向黑暗中逃跑的人们发射激光。

这是1984年《终结者》电影开场的场景描述。

小时候,这个场景让我做了噩梦。我以为这部电影展示了未来真正会发生的事情。

后来,我明白了这只是一部电影,但这个画面一直留在我的脑海中,伴随着一种存在主义的恐惧——人类发明的AI有一天可能会反噬人类。多年来,我童年的恐惧逐渐转变为对新兴技术的好奇,以及掌握它们的渴望。

但是……

当大语言模型(LLMs)向公众发布时,这种旧有的焦虑又回来了。AI将如何改变人类和我自己的生活,这个问题一直困扰着我。

为了找到答案,我让一个LLM经历了一系列测试,看看它到底有多聪明,以及它能否胜任我的工作。在每次测试中,LLM都需要证明其在分析用户研究数据时的准确性和可信度。我选择了用户研究分析,因为这是我十多年来掌握的技能。这让我能够将自己的工作与LLM进行对比,更重要的是,它让我直面那种存在主义的恐惧——AI可能会聪明到在未来取代我。

剧透警告,事实并非如此。

首先,我自己分析了用户研究参与者的访谈。接着,我让ChatGPT复制我所做的,并证明其可信度和准确性。这次经历让我感到谦卑,也让我大开眼界。它让我不再将LLMs视为敌人。我开始将ChatGPT视为我的研究助手,它虽然有限制,但在适当的监督下可以加快我的工作并发挥作用。以下是ChatGPT在每次测试中的表现。如果你对我一步步的操作感兴趣,或者想复制我的过程,请继续阅读。

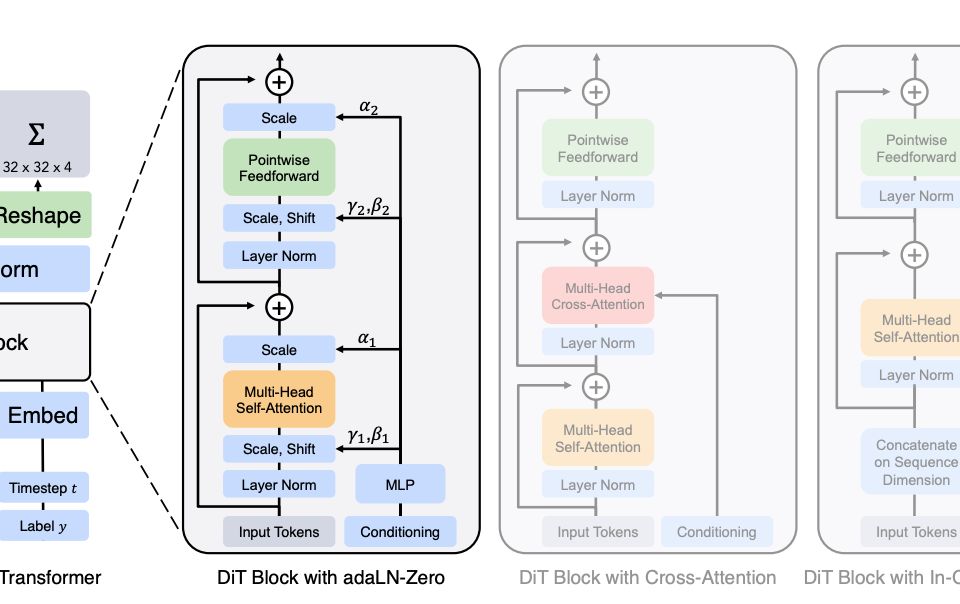

表1. 我让ChatGPT经历了一系列测试,看看它在分析定性用户研究数据方面的表现如何。这张表总结了学习成果。这些发现来自我自己的探索,不一定适用于其他定性数据或分析类型,也不一定代表其他用户研究人员使用LLMs的经验。

下面,我将一步步描述我所做的,并附上我使用的ChatGPT提示,以及一些不在表中的有趣发现。

关于研究问题和用于分析的数据

我使用了公开可用的用户访谈记录,以避免将敏感的参与者和专有信息输入LLM。该研究的作者采访了专家和当地社区的居民,探讨了曼谷某社区交通拥堵的原因。我的分析重点是找出所有讨论过的交通拥堵原因。我选择这个研究主题是因为它简单明了。我想看看LLM能否处理一个简单、研究充分的话题,其输出是总结所有交通拥堵的原因。访谈记录也很短(只有18页),这感觉是个不错的起点。

我在图1中一步步描述了分析过程,并附上了一些评论。

图1. 用户访谈记录的叙事分析和综合。一步步的讲解。我自己遵循了这个分析过程,然后让ChatGPT复制它。表1总结了它的表现。

方法论

我根据研究问题(曼谷Thung Khru交通拥堵的原因是什么?)和数据格式(访谈记录)选择了分析方法。在这种情况下,内容分析是最合适的。

第一步:编码定性数据

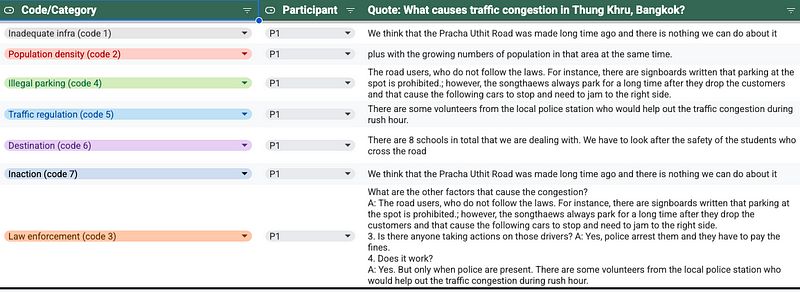

内容分析的第一步是对数据进行编码。编码是将定性数据分解为有意义的小块,并为这些数据块赋予标签。它让我能够将访谈记录分类为可消化的单元,然后将这些意义单元重新组织成更高层次的主题。它还让我能够看到参与者之间的模式。例如,如果大多数参与者提到基础设施差是导致交通拥堵的原因,那么这可能是一个关键发现,因为这是研究中大多数人的首要关注点。

以下是编码数据的示例:

表2. 定性数据编码。我如何编码参与者#1(P1)的用户访谈记录的示例。

完成编码后,我将同样的任务交给了ChatGPT。这归结为给ChatGPT一组提示。

我选择ChatGPT是因为我可以访问免费版本,并且输入文本限制足以完成分析。ChatGPT还可以生成表格形式的摘要,这对我需要做的事情很有帮助。

你可以下载匿名化的记录并使用下面的提示来复制我的步骤。我将原始记录从PDF复制粘贴到Google文档中以匿名化它们,但没有时间清理Google文档的格式,所以请见谅。好消息是ChatGPT不需要漂亮的格式来完成工作。

油管和这里)开发的。提示总是可以改进的,但它们已经足够好地完成了工作。我的一位从事LLMs工作的朋友告诉我,我可以让ChatGPT对提示进行反馈,并根据它的建议改进提示。下次我得试试。ChatGPT提示#1. 编码定性数据:

我希望你扮演一位专门从事定性分析的用户研究员。请审查记录,找出与研究问题“曼谷Thung Khru交通拥堵的原因是什么?”相关的摘录。生成最能代表所识别摘录的短语(即代码)。每个代码应为两到五个单词。你能以表格形式输出吗?[将匿名化记录复制粘贴到ChatGPT]

ChatGPT生成了代码及其对应的摘录,并将它们列在表格中。除了返回表格外,它还提供了一个摘要,其中包含它所谓的“见解”,试图列出它从记录中发现的内容。这些“见解”充其量只是表面观察,不符合我对见解的标准,我稍后会解释。

然后我接着使用了另一个提示,因为我忘了告诉ChatGPT列出每个摘录来自哪个访谈参与者:

ChatGPT提示#2. 编码定性数据:

你能在你生成的表格中添加第三列,并在其中列出摘录来自哪个参与者吗?

我使用参与者编号而不是真实姓名来匿名化数据。ChatGPT准确地将每个代码分配给了一个参与者。没有错误。

第二步:角色映射分析

交通拥堵是一个涉及多个参与者的问题,所以我决定进行角色映射分析,希望它能引导我找到更多发现。在角色映射中,你识别出访谈中提到的所有参与者、他们的行为和心理状态(认知、情感和报告言语)。有时参与者可以是物体或地点。我的角色映射分析包括第二次阅读记录,并列出访谈中提到的所有角色。

接下来,我让ChatGPT复制我的角色映射分析。

ChatGPT提示#3. 角色映射分析:

再次,我希望你扮演一位专门从事定性分析的用户研究员,并使用角色映射的方法。请审查相同的记录,并列出所有关键角色,如人和物体,它们在“曼谷Thung Khru交通拥堵的原因是什么?”中扮演了角色。生成角色,并为每个角色找到支持该角色在记录中被提及的证据的摘录。你能以表格形式输出吗?

ChatGPT在两次提示后找到并列出了比我更多的角色。我列出的角色与ChatGPT生成的角色有很多一致性。我仔细检查了每个角色对应的摘录,它们都来自记录。

接下来,我使用了另一个提示来分析剩余的访谈记录。

ChatGPT提示#4. 编码剩余记录的定性数据:

现在,我将给你另一份记录,它来自相同的访谈。再次,我希望你扮演一位专门从事定性分析的用户研究员。请审查记录,找出与研究问题“曼谷Thung Khru交通拥堵的原因是什么?”相关的摘录。生成最能代表所识别摘录的短语(即代码)。每个代码应为两到五个单词。你可以使用与第一份记录相同的代码,如果这有意义的话。文本是访谈记录,我不希望你编码采访者提出的问题。你能以表格形式输出吗?这是记录:

这是唯一一次ChatGPT编造了内容。我在提示中说:你可以使用与第一份记录相同的代码,如果这有意义的话,它说它做了。然而,当我查看输出时,它在这一步生成的所有代码都是新的。它没有重复使用任何之前的代码,但它说它做了。这让我深刻意识到要保持怀疑态度,并仔细检查ChatGPT的所有输出。

最后,我重复使用了提示#3,继续对剩余的记录进行角色映射。

第三步:开发高层次主题

在这一步中,我将代码组织成集群,将具有相似含义的代码分组在一起。每个代码集群形成一个高层次主题。我最终确定了几个主题,这些主题描述了曼谷Thung Khru交通拥堵的关键原因。一旦我确定了主题,我就回到原始数据中。我重新审视了代码,从参与者中提取摘录以丰富对主题的理解,并寻找例子以使过于笼统的主题更加具体和描述性。我还审查了角色映射分析中的角色列表,看看是否能获得任何额外的见解。

接下来,我让ChatGPT从其生成的代码中提取高层次主题:

ChatGPT提示#5. 开发高层次主题:

你能将这些陈述分组为不同的主题,并输出一个表格,显示哪些陈述属于哪个主题。主题应为2-5句话长,并专注于回答“曼谷Thung Khru交通拥堵的原因是什么?”这个问题。以下是一组陈述:[输入ChatGPT在前几步生成的所有代码]。

我在这里停下来,并将我的主题与ChatGPT生成的主题进行了比较。有很多相似之处。我们独立地达成了主要主题的一致。此外,我识别出了一些ChatGPT没有的主题,而ChatGPT也发现了一些我忽略的主题,这是一个双赢的局面。有一个LLM识别的主题让我意识到我得出了一些有偏见的结论,因此我能够纠正我的偏见,因为我正在与ChatGPT合作。

第四步:生成见解

见解不仅仅是主题、观察或学习,那么它们是什么呢?我喜欢以下几个定义:

见解是“基于他人生活真相的精心构建的解释性陈述,旨在影响他人的行动。”它们以“描述性、解释性和预测性”的叙事形式出现,其目的正是“描述、解释和预测”。~ Paul Hartley

Vijay Kumar的定义进一步扩展了它。“见解是通过观察并通过解释我们观察到的情况来‘看透’某种情况或理解其内在本质的行为。它是我们通过问为什么从观察中学习到的。”

见解是在研究人员获得他们的学习和观察后创建的。它们旨在引发“啊哈”时刻。它们促进理解的突破,并理想地推动人们采取行动或激发解决方案。

我在将代码综合成主题时,注意到了一些跳出来的见解。其中一个见解是关于交通拥堵的系统性本质,多个因素共同作用导致它。这意味着没有单一的解决方案可以解决交通拥堵问题,必须同时解决多个因素。生成见解既是艺术也是科学。通常,我会花更多时间生成见解,但我想专注于分析和综合。生成见解并测试LLMs在这方面的表现值得单独写一篇博客文章。

结论和限制

我最初对使用ChatGPT分析用户研究持怀疑态度,并且我仍然有很多问题。例如,LLM辅助分析是否合乎道德和安全?它有哪些偏见?无论如何,这个实验鼓励我继续测试。我了解到,与LLMs并肩工作就像与人类研究助手并肩工作一样。它们在可靠地编码和综合方面有优势(见表1),并且可以非常快速地处理大量定性数据。我的优势在于生成非显而易见的见解,我们可以在处理简单的研究问题时互补。使用LLMs仍然有一些重要的限制:

- 我输入到LLM的数据如何被模型使用是不透明的。我使用了匿名化的、公开可用的记录进行这个练习。然而,对于在工作中进行实际的用户研究,我需要非常清楚数据会发生什么,因为保护参与者隐私和专有信息非常重要。到目前为止,我还没有找到任何在线资源可以自信地解释数据一旦输入模型会发生什么。

- 模型总是有可能产生幻觉,所以我不放心在没有我的监督下部署ChatGPT独立进行分析。

- ChatGPT在回答简单的研究问题时是准确的,但我不确定它如何处理更大的数据集和更复杂的研究主题。

- LLMs只能辅助处理文本数据输入,这是有限制的。通常,用户研究人员会收集多种数据以了解上下文和非语言反应。他们还将定量数据与定性发现进行三角测量,添加先前研究的知识,进行思想实验以反思机会等。其他格式的数据如视频、图像、数字呢?人类研究人员在分析其他数据类型并连接各种数据类型之间的点方面仍然具有优势。

尽管有这些限制,我鼓励你尝试使用LLM来辅助定性分析。自己试试,并在评论中分享你的反思。

推荐阅读:

FluxAI 中文

© 2026. All Rights Reserved