微调 Flux.1 模型:专业人士的高级 AI 训练指南

超过 1 年前

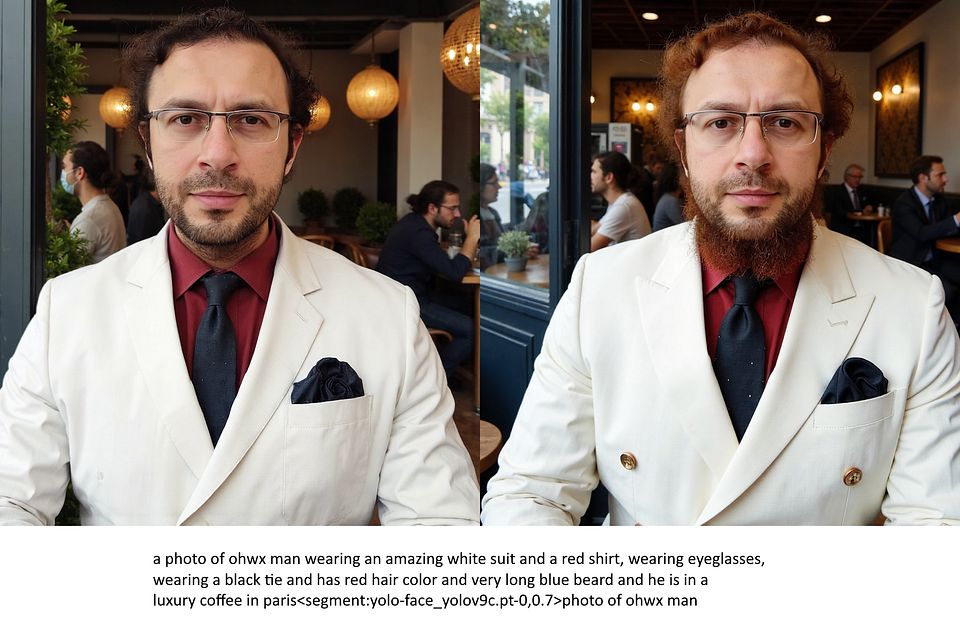

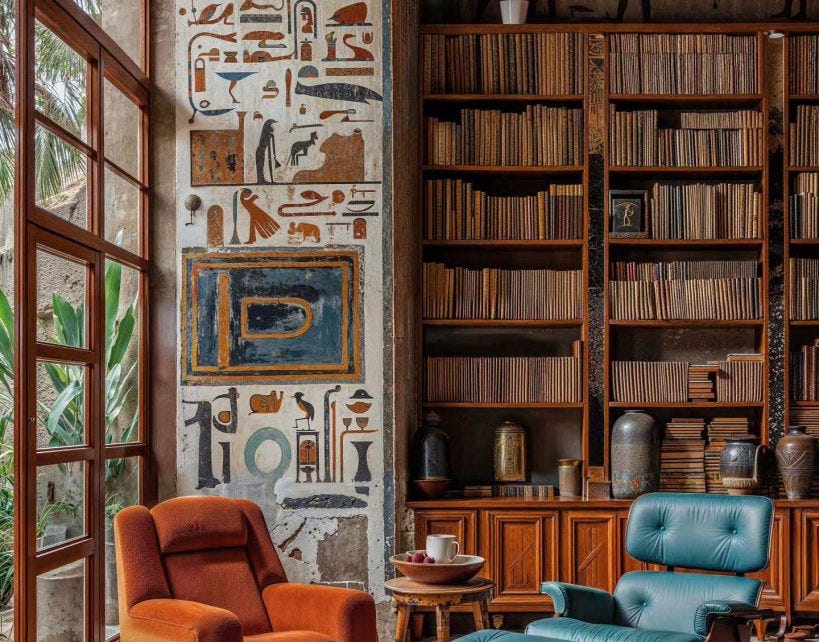

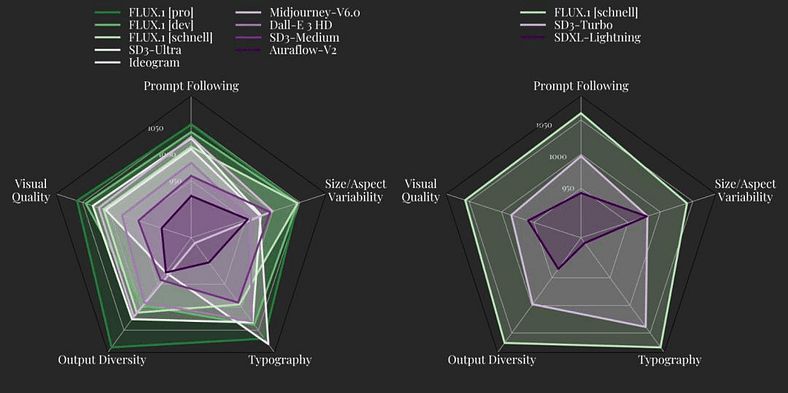

利用预训练模型并对其进行微调以适应特定任务,已成为提高效率和性能的核心策略。Flux.1 是一款前沿模型,通过微调可以实现无与伦比的性能。Flux.1 模型 主要用于 文本到图像生成。由 黑森林实验室 开发,Flux.1 采用先进的 AI 技术,结合 变换器和扩散架构,从详细的文本描述中生成高质量、视觉吸引力强的图像。该模型的参数数量达到 120 亿,擅长创建复杂场景、逼真的视觉效果以及多种艺术风格,从照片写实主义到抽象艺术应有尽有。

Flux.1 有几个版本:

- Flux.1 Pro:针对商业应用进行了优化,提供最高的视觉质量和详细输出,适合专业项目。

- Flux.1 Dev:开放权重版本,供非商业使用,提供高性能,适合个人项目。

- Flux.1 Schnell:最快的版本,适合快速本地开发和个人使用,内存占用较小。

该模型用途广泛,应用于 数字艺术、设计原型、市场视觉和教育内容 等多个领域。其生成详细且量身定制的图像的能力,使其成为需要快速、高质量视觉效果的创意专业人士的最爱。

Flux.1 还支持 多模态输入,这意味着用户可以整合详细的提示,描述对象、动作、光照、情绪和艺术风格。它是一个能够帮助用户轻松将创意愿景转化为具体视觉效果的工具。

微调 Flux.1 将使开发者和研究人员能够根据特定领域需求优化预训练模型,提高准确性并减少训练时间,同时优化资源利用。在本指南中,我们将详细介绍微调 Flux.1 的步骤,提供关键见解和实用代码片段,以确保顺利成功的过程。

为微调 Flux.1 设置环境

在深入微调过程之前,设置开发环境至关重要。正确的安装确保了顺畅的工作流程,使我们能够有效利用 GPU 加速 和处理大型数据集。

第一步:克隆代码库

第一步是克隆 AI 工具包代码库,该库包含微调 Flux.1 等模型所需的基本工具和脚本。

!git clone https://github.com/ostris/ai-toolkit.git

%cd ai-toolkit

该代码库提供了启动微调过程所需的一切,包括预训练模型和实用工具。

第二步:安装依赖项

安装所需的依赖项,包括 PyTorch 和 Hugging Face transformers 等基本库。

!pip3 install -r requirements.txt

确保安装 PEFT(参数高效微调)库,这对优化微调过程至关重要。

!pip install peft

此外,安装 PyTorch 和其他必要工具,以确保与您的 GPU 兼容。

!pip3 install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118

第三步:与 Hugging Face 进行身份验证

如果您使用 Hugging Face 进行模型管理,请登录您的 Hugging Face 账户,以便轻松访问和管理模型。

huggingface-cli login

准备微调的数据集

微调需要一个结构良好的数据集,以与您所针对的任务对齐,无论是 NLP、图像分类还是自定义领域任务。下一步是准备您的数据集以进行模型训练。

加载用于文本微调的数据集

在这个例子中,我们将使用 Hugging Face 数据集来加载和准备数据以进行微调。

from datasets import load_dataset

# 加载用于微调的数据集(例如,AG News)

dataset = load_dataset('ag_news')

# 对数据集进行预处理以进行标记化

def preprocess_function(examples):

return tokenizer(examples['text'], truncation=True, padding=True)

tokenized_dataset = dataset.map(preprocess_function, batched=True)

preprocess_function 对数据集进行标记化,为使用 Flux.1 模型进行训练做好准备。此过程包括填充和截断序列,以确保输入长度一致。

加载预训练的 Flux.1 模型

准备好数据集后,是时候加载 Flux.1 模型并准备微调了。

from flux_models import FluxModel, FluxTokenizer

# 加载预训练模型和标记器

model = FluxModel.from_pretrained('flux-model-1.0')

tokenizer = FluxTokenizer.from_pretrained('flux-model-1.0')

# 检查是否有可用的 GPU,否则使用 CPU

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

# 将模型移动到适当的设备(CPU 或 GPU)

model.to(device)

确保您的模型放置在正确的设备上,通常是 GPU,以便更快、更高效的训练。

定义微调过程

加载模型后,定义训练循环和微调过程。这包括设置超参数、定义优化器以及为多个周期设置训练循环。

定义超参数和优化器

设置训练参数,如学习率、批量大小和周期数。这些参数可以根据数据集的大小和任务的复杂性进行调整。

from torch.utils.data import DataLoader

from torch.optim import AdamW

# 准备数据加载器

train_dataloader = DataLoader(tokenized_dataset['train'], batch_size=32, shuffle=True)

# 设置优化器

optimizer = AdamW(model.parameters(), lr=5e-5)

微调的训练循环

以下是微调 Flux.1 模型的简单训练循环:

epochs = 3

for epoch in range(epochs):

model.train()

for batch in train_dataloader:

inputs = batch['input_ids'].to(device)

labels = batch['labels'].to(device)

outputs = model(inputs, labels=labels)

loss = outputs.loss

loss.backward()

optimizer.step()

optimizer.zero_grad()

print(f"第 {epoch + 1} 个周期完成。损失:{loss.item()}")

该循环在您的数据集上对模型进行多次周期的微调,使模型能够学习并适应特定任务。

评估微调后的模型

评估是确保模型在部署前表现最佳的关键步骤。使用验证数据集测试模型的准确性和性能指标。

评估代码

from sklearn.metrics import accuracy_score

# 切换模型到评估模式

model.eval()

def evaluate(model, dataset):

predictions, true_labels = [], []

for batch in dataset:

inputs = batch['input_ids'].to(device)

labels = batch['labels'].to(device)

with torch.no_grad():

outputs = model(inputs)

preds = outputs.logits.argmax(dim=-1)

predictions.extend(preds.cpu().numpy())

true_labels.extend(labels.cpu().numpy())

return accuracy_score(true_labels, predictions)

accuracy = evaluate(model, tokenized_dataset['test'])

print(f"准确率:{accuracy * 100:.2f}%")

此函数将使用准确率作为主要指标评估微调后的模型。对于更高级的任务,考虑添加精确度、召回率或 F1 分数,以进行更全面的评估。

以下是实现代码:

from sklearn.metrics import accuracy_score, precision_score, recall_score, f1_score, classification_report

# 切换模型到评估模式

model.eval()

def evaluate(model, dataset):

predictions, true_labels = [], []

for batch in dataset:

inputs = batch['input_ids'].to(device)

labels = batch['labels'].to(device)

with torch.no_grad():

outputs = model(inputs)

preds = outputs.logits.argmax(dim=-1)

predictions.extend(preds.cpu().numpy())

true_labels.extend(labels.cpu().numpy())

accuracy = accuracy_score(true_labels, predictions)

precision = precision_score(true_labels, predictions, average='weighted')

recall = recall_score(true_labels, predictions, average='weighted')

f1 = f1_score(true_labels, predictions, average='weighted')

print(f"准确率:{accuracy * 100:.2f}%")

print(f"精确度:{precision * 100:.2f}%")

print(f"召回率:{recall * 100:.2f}%")

print(f"F1 分数:{f1 * 100:.2f}%")

print("

分类报告:

", classification_report(true_labels, predictions))

return accuracy, precision, recall, f1

accuracy, precision, recall, f1 = evaluate(model, tokenized_dataset['test'])

微调的高级优化技术

1. 学习率调度

使用学习率调度器在训练过程中动态调整学习率,这可以显著提高性能。

from torch.optim.lr_scheduler import StepLR

scheduler = StepLR(optimizer, step_size=1, gamma=0.1)

2. 针对图像模型的数据增强

如果您正在对图像任务进行微调,请使用数据增强技术来提高模型的泛化能力。

from torchvision import transforms

transform = transforms.Compose([

transforms.RandomHorizontalFlip(),

transforms.RandomRotation(10),

transforms.Resize((224, 224)),

transforms.ToTensor(),

])

部署微调后的 Flux.1 模型

一旦您对微调后的模型的性能感到满意,就可以进行部署。将模型导出以便在 AWS、Google Cloud 或 Hugging Face 的模型库等云平台上部署。

保存微调后的模型

model.save_pretrained('./fine_tuned_flux')

将您的模型上传到 Hugging Face 或其他部署服务,并将其集成到您的应用程序中。

结论

充分发挥 Flux.1 模型的潜力,可以为软件开发和其他自定义用例开辟许多不同的机会。微调 Flux.1 模型可以显著提高特定任务的性能,使开发者能够利用预训练模型的优势,同时优化特定领域的需求。无论您是在处理自然语言处理、图像识别还是任何专业的 AI 任务,微调都提供了一条通往卓越的简化路径。

准备好提升您的 AI 模型了吗? 立即开始微调 Flux.1,这里是 Jupyter Notebooks 的代码:

有关更多信息,请参考 Flux.1 官方文档。

推荐阅读:

FluxAI 中文

© 2025. All Rights Reserved